הכירו את מודל הקוד הפתוח Kimi K2.5 מבית Moonshot AI שבא להפחיד את הענקיות

הכירו את Kimi K2.5: מודל הקוד הפתוח החזק בעולם. עם טכנולוגיית Agent Swarm המפעילה 100 סוכנים במקביל, גלו איך הוא

העולם של הבינה המלאכותית ממשיך להתפתח בקצב מסחרר, והפעם יש לנו חידוש שעשוי לשנות את חוקי המשחק. הכירו את QwQ-32B, מודל עם 32 מיליארד פרמטרים שמציג ביצועים מרשימים המשתווים ואף עולים על אלו של DeepSeek-R1 – מודל עם 671 מיליארד פרמטרים (מתוכם 37 מיליארד מופעלים). אז איך מודל קטן יותר מצליח להדביק ואף לעקוף את הגדולים? התשובה טמונה בסקיילינג נכון של למידת חיזוק (RL).

במשך שנים, המודלים הגדולים הסתמכו בעיקר על קדם-אימון (Pretraining) ואימון נוסף לאחר הלמידה (Post-training), אך מחקרים עדכניים מראים כי למידת חיזוק (Reinforcement Learning – RL) מאפשרת למודלים לשפר את יכולות החשיבה וההיגיון שלהם לרמות חדשות. השילוב של אימון רב-שלבי (Multi-stage Training) מעניק למודל את היכולת להתמודד עם משימות מורכבות בצורה מתוחכמת יותר, תוך הסתמכות על משוב מבוסס תוצאות.

ב-QwQ-32B, למידת החיזוק הותאמה באופן ייחודי לשיפור מיומנויות מתמטיות וקידוד. במקום להשתמש במודלי תגמול מסורתיים, QwQ-32B משתמש במאמת דיוק למתמטיקה (accuracy verifier) כדי לוודא שהתשובות נכונות ובשרת ביצוע קוד לבדיקת הצלחתן של התוכניות שנוצרות. תהליך זה מאפשר למידה מתמשכת ושיפור ביצועים עקבי בכל שלבי האימון.

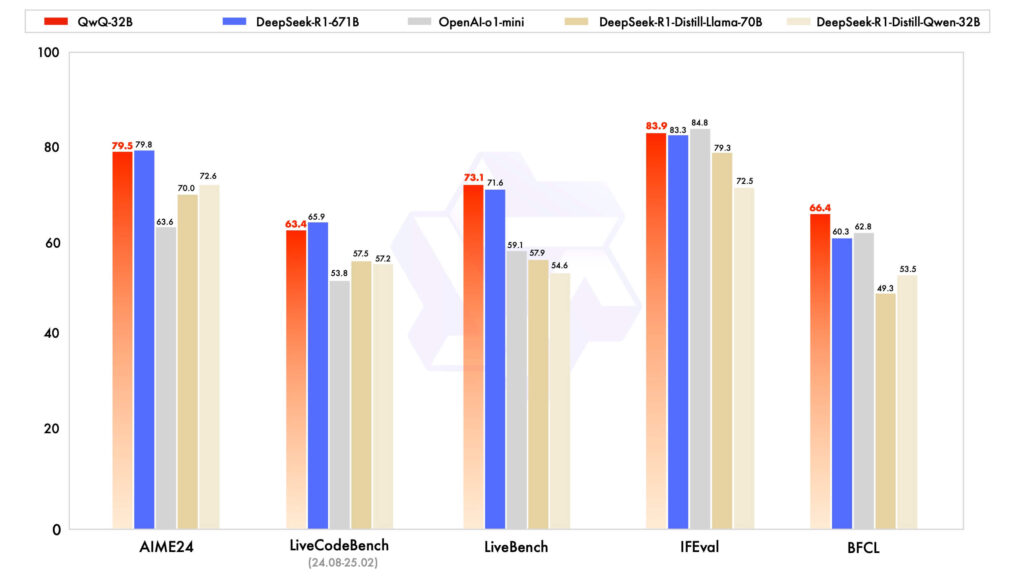

כאשר QwQ-32B הועמד למבחן מול מודלים מובילים כמו DeepSeek-R1-Distilled-Qwen-32B, DeepSeek-R1-Distilled-Llama-70B, o1-mini והמודל המקורי DeepSeek-R1, הוא הדגים ביצועים יוצאי דופן במשימות של פתרון בעיות מתמטיות, תכנות וחשיבה כללית. זה מוכיח כי למידת חיזוק בקנה מידה רחב (RL Scaling) יכולה לשפר משמעותית את יכולות המודל גם כאשר כמות הפרמטרים קטנה משמעותית ממודלים אחרים.

Benchmarks של QwQ (באדום) אל מול המודלים המתקדמים ביותר כיום

מעבר לביצועים הגבוהים, QwQ-32B כולל יכולת אינטגרציה של סוכנים חכמים (Agents), מה שמאפשר לו לא רק להציג תוצאות טובות יותר, אלא גם להתאים את החשיבה שלו בהתאם למשוב מהסביבה. המשמעות היא שהמודל לא רק מנתח מידע – אלא פועל עליו בצורה חכמה ומתקדמת יותר, צעד נוסף בדרך ליצירת בינה מלאכותית שמסוגלת לבצע משימות ברמות דמוי-אנושיות.

החדשות הטובות הן ש-QwQ-32B פתוח לשימוש תחת רישיון Apache 2.0 (קוד פתוח) וזמין ב-Hugging Face וב-ModelScope. המשמעות היא שכל מי שעוסק בחקר בינה מלאכותית, תכנות, או חישוביות יכול להוריד את המודל ולהתחיל לעבוד איתו באופן מיידי. בנוסף, ניתן לגשת אליו דרך Qwen Chat.

ההישג של QwQ-32B הוא רק הצעד הראשון במסע להרחבת השימוש ב-RL לשיפור יכולות החשיבה של מודלים גדולים. בעתיד, צפוי שהשילוב של מודלים חזקים יותר עם RL והגדלת משאבי החישוב יקרב אותנו ליצירת בינה מלאכותית כללית (AGI) – חלום שכל תעשיית הבינה המלאכותית שואפת אליו. יתרה מכך, אנו בוחנים שילוב מתקדם של סוכנים חכמים עם RL כדי לאפשר חשיבה ארוכת טווח (Long-horizon reasoning) ולהרחיב עוד יותר את גבולות היכולת של המודלים.

בהתחשב בכך שהוא מציג ביצועים שמתקרבים (ואף עולים) על מודלים גדולים פי כמה, התשובה היא כן – הוא המודל הטוב בעולם לגודלו. עם שימוש חכם בלמידת חיזוק, שילוב של אימון מבוסס תגמול, ויכולות הסתגלות לסביבה, QwQ-32B מספק הצצה לעתיד של בינה מלאכותית חכמה יותר, ממוקדת יותר, ויעילה הרבה יותר.

הכירו את Kimi K2.5: מודל הקוד הפתוח החזק בעולם. עם טכנולוגיית Agent Swarm המפעילה 100 סוכנים במקביל, גלו איך הוא

ב-16 בינואר 2026, OpenAI הטילה פצצה בעולם הטכנולוגיה כשהודיעה רשמית: הפרסומות מגיעות ל-ChatGPT והמהלך עורר סערה בקרב המשתמשים.

בעולם שבו המידע הרפואי שלנו מפוזר בין אפליקציות כושר, תיקים רפואיים דיגיטליים, שעונים חכמים וקבצי PDF, קשה מאוד לקבל תמונה

השאירו פרטים לחזרה